Google plus anunció una tecnología renovadora llamada CALM que hace más rápido modelos de lenguaje enormes (como GPT-3 y LaMDA) sin poner en una situación comprometedora los escenarios de desempeño.

Mucho más datos de entrenamiento es preferible, pero tiene un valor

Los modelos de lenguaje grande (LLM) se adiestran en enormes proporciones de datos.

El entrenamiento de modelos de lenguaje en enormes proporciones de datos provoca que el modelo aprenda novedosas capacidades que no en todos los casos están previstas.

Por poner un ejemplo, añadir mucho más datos de entrenamiento a un modelo de idioma puede ser inesperadamente en que consiga la aptitud de traducir entre distintas lenguajes, aun si no fué entrenado para llevarlo a cabo.

Estas novedosas capacidades se nombran capacidades emergentes, capacidades que no están siempre organizadas.

Otro trabajo de investigación (PDF) sobre capacidades emergentes establece:

«Si bien hay docenas de ejemplos de capacidades emergentes, en la actualidad hay escasas explicaciones contundentes de por qué razón semejantes capacidades brotan de la manera en que lo hacen».

No tienen la posibilidad de argumentar por qué razón se aprenden distintas capacidades.

Pero se conoce que acrecentar la proporción de datos para entrenar a la máquina le deja conseguir mucho más capacidades.

La desventaja de acrecentar los datos de entrenamiento es que se precisa mucho más poder de balance para generar una salida, lo que provoca que la inteligencia artificial sea mucho más lenta al producir la salida de artículo (un punto llamado «tiempo de inferencia»).

Entonces, la compensación de lograr que una inteligencia artificial sea mucho más capaz con mucho más datos es que la inteligencia artificial asimismo se regresa mucho más lenta en el instante de la inferencia.

El nuevo trabajo de investigación de Google plus (Modelado de lenguaje adaptativo seguro PDF) detalla el inconveniente de la próxima forma:

“Los adelantos recientes en modelos de lenguaje grande (LLM) basados en transformadores llevaron a novedades de desempeño importantes en muchas tareas.

Estas ganancias surgen de un incremento dramático en el tamaño del modelo, lo que puede conducir a un empleo retardado y caro en el instante de la deducción.

Modelado de lenguaje adaptativo seguro (CALM)

Los estudiosos de Google plus han encontrado una solución atrayente para apresurar los modelos de lenguaje sosteniendo un prominente desempeño.

La solución, por llevar a cabo una analogía, es un tanto como la diferencia entre contestar una pregunta simple y solucionar una mucho más bien difícil.

Una pregunta fácil como de qué color es el cielo puede responderse con algo de reflexión.

Pero una contestación bien difícil necesita que te detengas y supongas un tanto mucho más para hallar la contestación.

Computacionalmente, los modelos de lenguaje grande no distinguen entre una sección bien difícil de una labor de generación de artículo y una sección simple.

Desarrollan artículo tanto para las partes simples para las bien difíciles usando su capacidad informática en el instante de la deducción.

La solución de Google plus lleva por nombre Modelado de lenguaje adaptable seguro (CALM).

Lo que hace este nuevo marco es gastar menos elementos en las partes triviales de una labor de generación de artículo y dedicar todo el poder a las partes mucho más bien difíciles.

El trabajo de investigación sobre CALM establece el inconveniente y la solución de la próxima forma:

“Los adelantos recientes en modelos de lenguaje grande (LLM) basados en transformadores llevaron a actualizaciones de desempeño importantes en muchas tareas.

Estas ganancias van acompañadas de un incremento increíble en el tamaño del modelo, lo que puede conducir a un empleo retardado y caro en el instante de la deducción.

En la práctica, no obstante, la serie de generación construída por el LLM se compone de niveles diferentes de contrariedad.

Al paso que ciertas conjeturas verdaderamente aprovechan todo el potencial de los modelos, otras continuaciones son mucho más triviales y tienen la posibilidad de resolverse con ciertos cálculos.

…A pesar de que los modelos enormes en general marchan mejor, posiblemente no se requiera exactamente la misma proporción de balance a fin de que cada entrada consigua un desempeño afín (por poner un ejemplo, en dependencia de si la entrada es simple o bien difícil)”.

¿Qué es Google plus CALM y marcha?

CALM marcha a través de la asignación activa de elementos dependiendo de la dificultad de la parte individual de la labor, usando un algoritmo para adivinar si algo precisa elementos totales o parciales.

El trabajo de investigación comparte que probaron el nuevo servicio en múltiples tareas de procesamiento de lenguaje natural («resumen de artículo, traducción automática y contestación a cuestiones») y se dieron cuenta que podían apresurar la inferencia en un aspecto de precisamente tres (300%). .

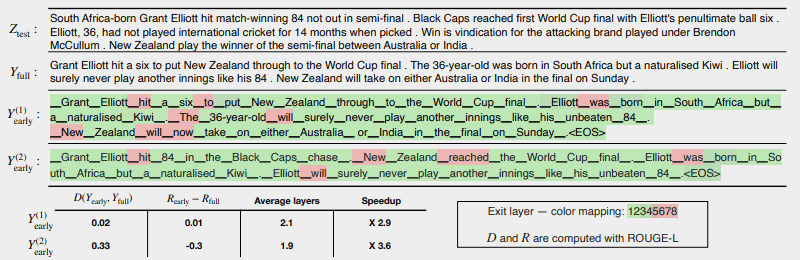

La próxima ilustración exhibe de qué forma marcha el sistema CALM.

Las escasas áreas en colorado indican dónde la máquina debió emplear su aptitud total para esa sección de la carga.

Las áreas en verde son donde la máquina solo ha utilizado menos de la mitad de su aptitud.

Colorado = Aptitud total/Verde = Menos de media aptitud

O sea lo que afirma el trabajo de investigación sobre la ilustración previo:

“CALM hace más rápido la generación al irse temprano en el momento en que resulte posible y emplear selectivamente la aptitud completa del decodificador para solo unos pocos tokens, probado aquí en un caso de muestra de CNN/DM con una medida de seguridad fundamentada en softmax. Y(1) y también Y(2) usan distintas umbrales de seguridad para la salida adelantada.

Bajo el artículo (sic), notificamos la rigidez textual y el peligro medidos para todos los 2 desenlaces, adjuntado con las ganancias de eficacia.

Los colores representan el número de escenarios de decodificación empleados para cada ficha: los tonos de verde claro indican menos de media parta de los escenarios totales.

Solo unos pocos tokens elegidos emplean la aptitud total del modelo (coloreados en colorado), al paso que para la mayor parte de los tokens, el modelo sale tras una o múltiples capas de decodificación (coloreados en verde).

Los estudiosos concluyeron el archivo señalando que la implementación de CALM necesita solo cambios mínimos para escalar un modelo de lenguaje grande a fin de que sea mucho más veloz.

Esta investigación es esencial pues abre la puerta a la construcción de modelos de inteligencia artificial mucho más complejos que se adiestran en conjuntos de datos substancialmente mucho más enormes sin presenciar una agilidad mucho más lenta y sosteniendo un prominente nivel de desempeño.

No obstante, este procedimiento asimismo puede favorecer a los modelos de lenguaje enormes que se adiestran con aun menos datos.

Por poner un ejemplo, los modelos InstructGPT, de los que ChatGPT es un modelo hermano, se adiestran en precisamente 1300 millones de factores, pero aún tienen la capacidad de sobrepasar a los modelos entrenados en considerablemente más factores.

Los estudiosos concluyeron:

“Por norma general, nuestro marco integral de computación adaptativa para LM necesita cambios mínimos en el modelo subyacente y deja ganancias de eficacia al tiempo que cumple con estrictas garantías de calidad para la producción”.

Esta información sobre este trabajo de investigación se termina de divulgar en el blog de Google plus AI el 16 de diciembre de 2022. El trabajo de investigación en sí tiene fecha del 25 de octubre de 2022.

Va a ser atrayente ver si esta tecnología se abre sendero en enormes modelos de lenguaje más adelante próximo.

Lea la publicación del blog de Google plus:

Aceleración de la generación de artículo con modelado de lenguaje adaptativo seguro (CALM)

Lea el producto de investigación:

Modelado de lenguaje adaptativo seguro (PDF)

Imagen cortesía de Shutterstock/Master1305

Fuente: searchenginejournal

Hashtags: #nuevo #modelo #tecnología #del #charla

Comentarios recientes